Deep Fake Videos sind die neuen Fake News!

Von Marc Recker, fischerAppelt

Wir dürfen die Gefahr, die von Deep Fake Videos ausgeht, nicht unterschätzen.

Vor kurzer Zeit imitierte Schauspieler Bill Hader während eines Video-Interviews mit Conan O’Brien die Terminator-Ikone Arnold Schwarzenegger. Die ideale Vorlage für den slowakischen Youtuber „Ctrl Shift Face“ – er verwandelte in einer neuen Version das Gesicht von Bill Harder in das von Arnold Schwarzenegger. Doch ein Deep Fake ist nicht nur eine nette, technische Spielerei. Die manipulierten Videos können ernsthafte Folgen haben.

Wo genau aufwändig inszenierte Fakes ihren Ausgangspunkt haben, ist schwer zu sagen – ein Meilenstein ist sicherlich eine Inszenierung der Aktivistengruppe „The Yes Men“ aus dem Jahr 2004. Sie stellten eine falsche Webseite der Welthandelsorganisation (WTO) ins Netz und erhielten darüber Einladungen zu Konferenzen. Dort agierten sie dann als Vertreter der WTO. Zu ihren legendären Erfolgen zählt der „Dow Chemical Hack“. Als vermeintliche Vertreter der WTO versprachen sie Opfern eines Chemieunfalls – live im BBC Fernsehen und vor Millionen von Zuschauern zwölf – Milliarden Dollar Entschädigung. Daraufhin musste das Unternehmen Dow Chemical erklären, dass sie weder rechtlich zur Verantwortung gezogen werden könnten, noch zu Zahlungen bereit seien.

Seitdem legte der Begriff „Fake News“ eine steile Karriere hin – von Satire zum politischen Kampfbegriff. Zunächst nutzte „The Daily Show“ oder „The Onion“ das Label ‚Fake News‘ als Überschrift für ihre eindeutig satirischen Meldungen, um sie von echten Nachrichten abzugrenzen. Erst nachdem während des Präsidentschaftswahlkampfs von Donald Trump in den USA eine große Anzahl politisch motivierter Falschmeldungen in den Umlauf kamen, die den Ausgang der Wahl beeinflusst haben sollen, setzte sich der Begriff im allgemeinen Sprachgebrauch durch. Seitdem streiten und forschen Experten zum Thema Fake News. Welche Auswirkungen haben sie auf die Gesellschaft? Was, wenn die Wahrheit zwischen Alternativen untergeht?

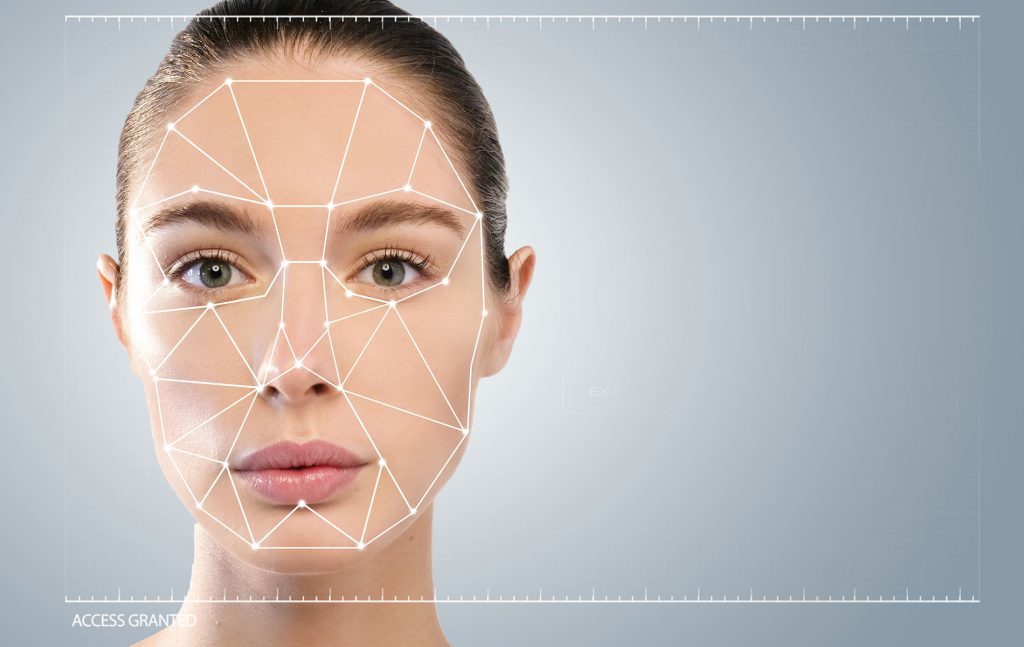

„Was ich sehe ist wahr“ – Deep Fake bringt den geglaubten Grundsatz ins Wanken

Eine Vielzahl von Experten behauptet, dass „Fake News“ grundsätzlich beherrschbar seien, da sich alle Informationen durch andere Quellen abgleichen und so verifizieren lassen. Das ist zwar aufwendig, sorgt jedoch dafür, dass Lügen entlarvt werden können. Kritisch wird es, wenn sich Kampagnen auf visuelle Quellen beziehen, die das scheinbar Offensichtliche zeigen: Menschen glauben, was sie sehen. Es ist fast unmöglich, jemanden vom Gegenteil zu überzeugen, wenn man etwas mit eigenen Augen meint, gesehen zu haben. Das ist das Prinzip von Deep Fake. Der Begriff bezeichnet eine Technik, bei der jemand mithilfe von Künstlicher Intelligenz (KI) real wirkende, manipulierte Videos oder Bilder erstellt. Die Basis dafür bilden künstliche neuronale Netzwerke, die meistens autonom erzeugt werden. Die KI macht so schnelle Fortschritte, dass es ohne technische Hilfsmittel bald fast unmöglich sein wird, zwischen fake und real zu unterscheiden.

Ein anonymer Reddit-User stellte im Herbst 2017 mehrere Pornovideos ins Netz mit Schauspielerinnen wie Emma Watson oder Katy Perry. Doch diese Szenen wurden mit Hilfe von künstlicher Intelligenz produziert und sind nicht echt. Um das neuronale Netz zu trainieren, hatte der Nutzer Spielfilmszenen der Stars mit pornographischen Videos kombiniert. Im Herbst 2018 publizierte der US-amerikanische Comedian Jordan Peele ein Video von Barack Obama, dem ehemaligen US-Präsidenten. Dort ließ er Obama vor den Gefahren manipulierter Videos warnen und den Nachfolger Donald Trump als „kompletten Volltrottel“ bezeichnen.

Seit Ende Januar 2018 können Amateure mit der sogenannten FakeApp ganz einfach selbst Gesichter in Videos austauschen. Dafür verwendet sie einen Algorithmus, der mithilfe eines künstlichen neuronalen Netzes, Grafikprozessorleistung und ein paar Gigabyte Festplattenspeicher das Video

errechnet. Für ein genaueres Ergebnis benötigt das Programm viel Bildmaterial von der Person, die eingesetzt werden soll. Durch die Videosequenzen und Bilder lernt der für Deep-Learning-Algorithmus, welche Elemente ausgetauscht werden müssen. Dafür verwendet die Software das KI Framework TensorFlow von Google, das schon für das Programm DeepDream im Einsatz war. Und die neue Generation steht schon bereit. Gerade hat Samsung eine Deep-Fake-KI präsentiert, die ein gefälschtes Video von einer Person aus einem Profilfoto erstellen kann.

Fast alle großen Technologiefirmen arbeiten an der Technologie, die hochwertige Deep Fake Videos erstellt – aber auch bei bösartiger Absicht missbraucht werden. Sogar ein schlecht gefälschtes Video von Nancy Pelosi, US-Sprecherin des US-Repräsentantenhauses, ging viral und zeigt, wie die Masse getäuscht werden kann, da die Deep Fakes schwer zu entlarven sind. Medienforensik-Forscher Hany Farid sagt dazu: „Diese Art von Techniken und ihre rasante Entwicklung bergen das hohe Risiko von Fehlinformationen, Wahlmanipulationen und Betrug.“

Der Fallstrick unserer Zeit: Einseitiger Medienkonsum in der Bubble und zu glauben, was man sieht

Es ist bemerkenswert, wie wenig aktuell über die Gefahren von Deep Fake Videos diskutiert wird. Es braucht nicht viel Fantasie, sich überlegen, wie viel Schaden manipulierte Fotos oder Videos bei Personen und gesamtgesellschaftlich anrichten können. Dass wir uns „bisher auf Videos als Beweis für Tatsachen verlassen konnten“ sieht Ian Goodfellow, Ingenieur bei Google, als einen „historischen Glückfall“. Digital Natives scheinen weniger bereit, lange Texte zu lesen und überprüfen danach nicht unbedingt bei verschiedenen Quellen, ob die Informationen des gelesenen Artikels stimmen. Eher konsumieren sie Bewegt-Bild-Content. Wenn sie dann einem Deep Fake Video auf den Leim gehen, kann das eh schon angeschlagene Vertrauen in die Medien weiter bröckeln. Und rechtlich können die Urheber der gefälschten Videos kaum belangt werden, da sie sich problemlos in die Anonymität flüchten.

Die Verantwortung liegt bei den großen IT-Konzernen

Es liegt auch an uns, durchweg auf das Thema Deep Fake und den damit zusammenhängenden Gefahren hinzuweisen. Die großen Leitmedien sollten zumindest Experten beschäftigen und technisch aufrüsten, um manipulierte Videos entlarven zu können. Doch an erster Stelle müssen die großen Internetkonzerne Verantwortung übernehmen. Sie müssen Methoden entwickeln, Videos, die mit ihrer KI bearbeitet wurden, nachhaltig zu kennzeichnen. Sonst kann diese Technologie als Waffe genutzt werden. Und Menschen werden sie für ihre persönlichen Zwecke einsetzen. Die Lawine ist bereits losgetreten!

Kommentare zu diesem Beitrag

Einen Kommentar hinzufügen